虽然现在的AI技术还不够。但新研究表现出了令人鼓舞的进步迹象,从能找出满足基本命令的步骤的机器人到能从解释中学习的文本生成系统。在Techcrunch日前恢复的《Deep Science》中,他们将每周都会介绍AI和更广泛的科学领域的最新发展,他们将介绍DeepMind、Google和OpenAI的工作--这些工作正朝着系统能够以令人印象深刻的稳健性解决诸如生成图像的狭窄任务的方向迈进。

AI研究实验室OpenAI的DALL-E改进版--DALL-E 2很容易成为AI研究实验室深处出现的最令人瞩目的项目。TechCrunch记者指出,虽然最初的DALL-E展示了创造图像以匹配几乎任何提示的非凡能力,但DALL-E 2在这方面更进一步。它产生的图像更加详细,且它还可以智能地替换掉图像中的特定区域--比如将一张桌子插入充满适当反射的大理石地板的照片中。

虽然DALL-E 2本周受到了大部分的关注,但在周四,Google的研究人员在GoogleAI博客上所介绍的一个视觉理解系统同样令人深刻。据悉,这个系统被称为视觉驱动的文字转语音(Visually-Driven Prosody for Text-to-Speech,简称VDTTS)。VDTTS可以生成听起来很真实的唇语,除了文字和说话的人的视频帧之外,没有其他东西。

VDTTS生成的语音虽然不是录制的对话的完美替代品,但表现相当好,它具有令人信服的人类表达能力和时间。Google认为有一天它可以在演播室中使用,从而取代可能在嘈杂条件下录制的原始音频。

当然,视觉理解只是通往更有能力的AI道路上的一个步骤。另一个组成部分是语言理解,它在许多方面都落后于人--即使抛开AI有据可查的毒性和偏见问题。一个鲜明的例子是,根据一篇论文,Google的一个尖端系统Pathways Language Model(PaLM)记住了用于“训练”它的40%的数据,结果PaLM剽窃了代码片段中的文本,甚至是版权声明。

所幸的是,由Alphabet支持的AI实验室DeepMind也在探索解决这一问题的技术。在一项新研究中,DeepMind的研究人员研究了AI语言系统--它们学会从许多现有文本的例子中生成文本--是否可以从对这些文本的解释中获益。在对几十个语言任务进行注释后并评估了不同系统在这些任务上的表现,DeepMind团队发现,例子确实提高了系统的表现。

DeepMind的方法如果在学术界获得通过,那么有朝一日将可以应用到机器人技术中、形成机器人的构件并在无需一步步指示的情况下理解模糊的请求。尽管存在很大的局限性,但Google新的Do As I Can, Not As I Say项目还是让人们看到了这个未来。

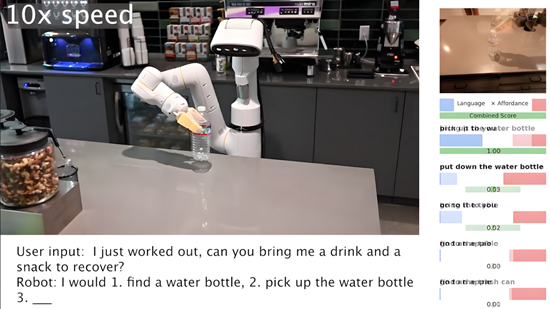

作为Google的机器人技术和Alphabet的X实验室的日常机器人技术团队之间的合作,“Do As I Can, Not As I Say”项目旨在为AI语言系统提供条件以便为机器人提出可行的且适合环境的行动。机器人充当语言系统的“手和眼睛”,而系统则提供关于任务的高级语义知识--理论上,语言系统编码了大量对机器人有用的知识。

此外,一个名为SayCan的系统则可以选择机器人在响应命令时应该执行的技能,其中它将特定技能有用的概率和成功执行该技能的可能性考虑在内。如如果有人说:“我的可乐洒了,你能给我拿点东西来清理吗?”SayCan可以指示机器人找到一块海绵,拿起海绵,然后将它送到提出该要求的人手中。

不过SayCan受到了机器人硬件的限制--研究小组不止一次观察到他们选择用来进行实验的机器人意外地掉落物体。尽管如此,它跟DALL-E 2和DeepMind在语境理解方面的工作一起说明了AI系统如何在结合时使我们人类更接近于杰森一家式的未来。